2023-07-26

3000字还原Meta如何执行自己的内容审核系统!

Meta广告系统

Meta会使用技术和审核团队来检测、审核每天在Facebook和Instagram发布的众多内容,并对违规的内容采取措施。那么,Meta是如何执行自己的这套政策系统的呢?今天我们就一起走近Meta政策系统,帮助大家更好的了解Meta这个平台,更顺利的做Meta的广告投放!

一、检测违规内容

技术和审核团队可以帮助Meta检测和审核潜在的违规内容和账户。检测主要分为两个部分:技术和审核团队。

1.技术

Meta技术可以在用户举报前就主动检测到绝大部分违规内容并将其移除。Meta的工程师和数据科学家将与审核团队携手,不断更新并改进这项技术。同时,Meta技术还有助于审核团队确定内容的优先级。

①如何利用技术检测违规内容

Facebook和Instagram上的用户每天发布的内容多达数十亿条。即使全世界有成千上万的审核员,他们也无法亲力亲为地审核所有内容。这也是Meta引入人工智能技术的原因。在用户举报之前移除的内容中,有超过90%是由技术检测而出。另外,Meta的技术检测到潜在的违规内容后,会将它们发送给审核团队进行审核并采取适当的措施。

其实利用技术检测违规内容很简单,某条帖子要么违反了相关政策,要么没有。但对于有些“情绪不明”、“语言表达特别复杂”、或者“要解读其中使用的图像”、“需要深度分析其背景信息”的帖子,则需要采用人工审核来深入分析。

在决定人工审核团队应该优先审核的内容时,Meta主要会从以下3个因素来考虑:

A.严重程度:这些内容在线上或线下造成伤害的可能性有多大?

B.传播力:这些内容被分享的速度有多快?

C.违规概率:这些内容实际上违反了Meta政策的概率有多高?

2.审核团队

全球有超过15,000名审核员负责审核Facebook和Instagram平台上的违规内容。他们都接受了深度培训,并通过专注于某些政策领域和地区,总共可以审核50多种语言的内容。

这些审核人员来自不同的背景,体现了Meta社群的多元化,而且他们都拥有丰富的工作经验,包括退伍军人、法律专家、儿童安全、仇恨言论和反恐等政策领域的政策执行专家等等,作为Meta内容执行系统的重要分支,审核团队必须具备一定的语言能力和文化能力才能胜任这份工作。

例如,某个菲律宾用户在半夜举报了一篇塔加拉族语的帖子,Meta的系统就会将其推送给当地或其他时区会讲塔加拉族语的审核员,让他们进一步审核。在识别不同文化的诽谤言论时,必须雇佣了解内容的具体含义、文化背景、当地名人或时事新闻的审核员,才能清楚帖子的必要背景信息,从而准确地执行Meta的政策。

二、采取措施

Meta对Facebook和Instagram上违规内容的执行措施分为3类:移除、删减和告知。

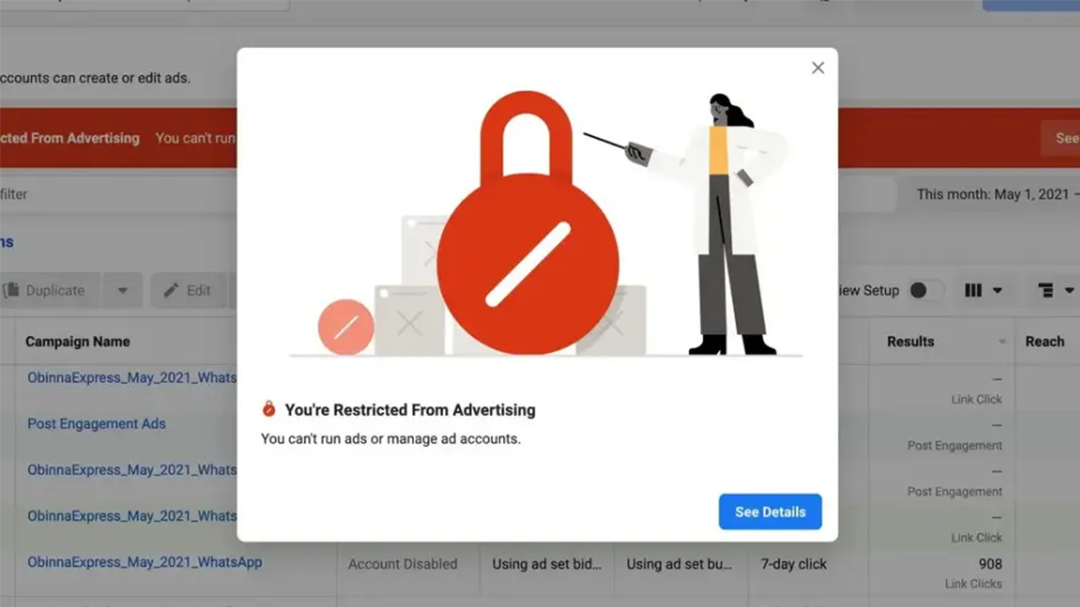

图片移除

Facebook和Instagram的社群守则里分别概述了Facebook允许和禁止发布的内容。一旦发现违反了相关政策的内容,Meta就会立即将其移除。

Meta也会向用户发送通知,告知用户为什么会移除该内容,以及今后该如何避免分布违规内容。同时使用违规计分系统记录违规行为,督促用户为自己发布的内容承担责任。最后还要看用户的内容所违反的具体政策,包括历史违规记录和违规计分次数,看是否要限制或停用该账号。

对于Facebook上大多数的违规行为,违规计分将导致以下限制:

1次违规记分:将向您发出警告,因为这是您首次违规记分。

2到6次违规记分:禁止您在特定期限内使用某些功能,例如在小组内发帖。

7次违规记分:1天内禁止创建内容,包括发帖、评论、创建公共主页等。

8次违规记分:3天内禁止创建内容。

9次违规记分:7天内禁止创建内容。

10次或更多次违规记分:30天内禁止创建内容。

如果经一再警告和限制后,用户仍然继续发布违反 Facebook 社群守则或 Instagram 社群守则的内容,Meta将禁用用户的帐户。

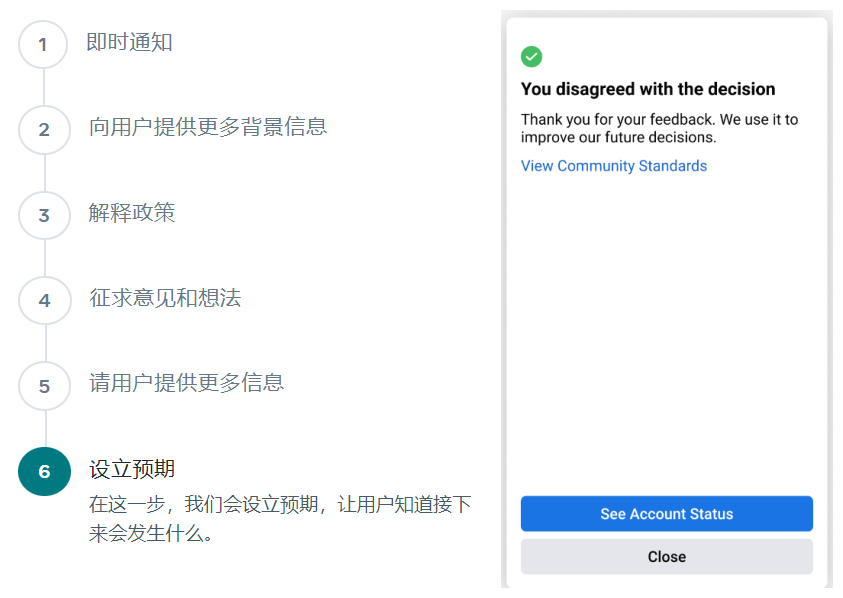

如果用户觉得是Meta出现了误判,也是可以通过“联系我们”进行复审的。

1.删减

有一些问题内容可能会给Facebook和Instagram用户带来负面的体验,即便这些内容不太符合Meta的政策所规定的移除标准,但Meta通常也会减少它们的传播。具体是如何操作的呢?

①根据用户的直接反馈做出改善

Meta经常询问用户他们在 Facebook 获得的体验如何,并且通过问卷调查来更好地了解我们提供的服务。Meta会考量用户的意见,以及可表明他们喜欢、不喜欢、评论或分享的内容的信号。根据这些反馈,Meta会处理许多类型的问题内容,包括:

劣质内容,比如点击诱饵和互动诱饵。

指向满是广告、加载缓慢或已经损坏的网站的链接。

被反复复制粘贴的劣质评论。

②鼓励广告主制作高质量的内容

Meta希望用户看到的内容既有趣又新颖,因此努力制定各种激励措施,鼓励广告主制作优质内容。但Meta不鼓励发布以下内容:

转自其他来源的有限原创内容。

滥用视频或直播视频格式的劣质视频。

错误信息。

③营造一个更安全的社群

对于某些内容,有的用户可能想看,但其他人可能会觉得存在问题,所以Meta会减少其曝光度。这类内容包括:

屡次违反我们政策的创作者发布的内容。

2.告知

如果内容可能具有敏感性或误导性,Meta有时也会添加警告或分享来自独立核查机构的其他信息,这么做的目的是为了避免用户看到潜在的敏感内容。以下是Meta为可能具有敏感性或误导性的内容提供背景信息的一些方法:

①为Facebook和Instagram上的敏感内容添加警告画面

用户非常重视能够在线讨论一些重要且通常很棘手的问题,但他们对某些类型的内容的敏感程度各不相同。因此Meta会为Facebook上的潜在敏感内容添加警告画面,例如:

暴力或血腥图像。

包含欺凌或骚扰内容的帖子,前提是分享帖子是为了提高认识。

某些形式的裸露内容。

与自杀或试图自杀有关的帖子。

②Facebook、Instagram和messenger中的认证徽章

为了打击冒充行为并帮助用户鉴别伪装成知名人士的骗子,Meta 会为已认证的公共主页和个人主页授予认证徽章,表明其身份。这意味着Meta确认此帐户是其代表的公众人物、名人或品牌/公司的真实帐户。

如何在Facebook申请认证徽章?

https://www.facebook.com/help/1288173394636262/

③Facebook应用中过时文章的通知画面

为了在用户将新闻报道分享到 Facebook 之前为其提供更多背景信息,Meta 会在发布时间超过 90 天的文章上显示一个通知画面。然后,用户可根据需要继续分享。此通知可帮助用户了解特定新闻报道发布了多久及其来源。

为了确保Meta不会减缓可靠信息的传播,尤其是卫生领域的信息,由政府卫生部门和公认的全球卫生组织发布的内容不会显示此通知画面。这也是为什么很多用户在Facebook上分享他人帖子时会看到通知画面的原因。